I televisori UHD (Ultra High Definition) sono capaci di restituire immagini incredibilmente più realistiche rispetto ai “vecchi” Full HD. Il merito non è (solo) della quadruplicata risoluzione, ma (soprattutto) di una caratteristica che accompagna l’aumento di risoluzione e che si chiama High Dynamic Range. Purtroppo esistono diversi “standard” per la codifica dell’HDR e questa situazione potrebbe rendere ancor più complicato orientarsi nella scelta del televisore “giusto”. HDR 10, Dolby Vision, Hybrid Log-Gamma… Cosa si nasconde dietro l’HDR e ai suoi molti nomi?

“Con quanti nomi puoi chiamare Dio? Puoi chiamarlo, se vuoi, in mille maniere: Dio, Visnù, Budo, Ernsto, Crisma, Giove, Allah… tanto, non ti risponde…” (Brunello Robertetti, alias Corrado Guzzanti). E con quanti nomi puoi chiamare l’HDR? HDR 10, Dolby Vision, Hybrid Log-Gamma… tanto è sempre uno spettacolo… Che il salto qualitativo tra Full HD e UHD sia epocale è fuori discussione. Il realismo delle immagini UHD sta a quello del Full HD come il suono di un impianto hi-fi sta a quello di un “compattone”. Tre sono gli elementi essenziali da tenere in considerazione nel passaggio dal vecchio Full al nuovo Ultra: l’aumento della risoluzione, l’ampliamento dello spazio colore e della relativa “profondità” ed infine l’incremento della dinamica luminosa. Questo articolo verte essenzialmente sul secondo e terzo aspetto, ma prima di entrare nel merito diciamo qualcosa anche sul primo, che è totalmente a sé, mentre gli altri due sono fortemente interconnessi.

L’aumento di risoluzione è l’evoluzione tecnologica più evidente e più facile da comprendere ma è, passatemi la provocazione, anche quella che a mio avviso contribuisce in misura minore al risultato finale. Una immagine Full HD è composta da poco più di 2 milioni di pixel, per la precisione 1.920×1.080, ciascuno dei quali, non dimentichiamolo, è a sua volta costituito da una terna di “sub-pixel”, uno rosso, uno verde ed uno blu.

Il passaggio dal Full HD all’Ultra High Definition prevede il raddoppio della risoluzione orizzontale e verticale delle immagini, risoluzione che passa quindi a 3.840×2.160. Di conseguenza il numero di pixel quadruplica: in un pannello UHD i punti che compongono l’immagine sono oltre 8 milioni. A parità di diagonale dei pannelli, i pixel di un TV UHD sono più piccoli di quelli di un TV Full HD. Perché questa riflessione apparentemente ovvia è invece molto importante? Per capirlo dobbiamo tenere presente le prestazioni del nostro apparato visivo, in particolare il potere risolutivo dell’occhio. In estrema sintesi il potere risolutivo è la capacità dell’occhio di percepire da una certa distanza come distinti due punti tra loro vicini, distanza oltre la quale essi si confondono in un punto solo. Tanto più i due punti distinti sono piccoli e ravvicinati, tanto minore sarà la distanza oltre la quale essi sfumeranno in un punto solo.

Stante questo limite, o meglio questa naturale condizione della nostra vista, se la distanza dalla quale ci poniamo a guardare il televisore fosse troppo grande, finiremmo col non essere più in grado di cogliere le differenze in termini di risoluzione tra un televisore Full HD ed uno UHD. Una regola empirica per stabilire la giusta distanza di visione è quella che consiglia di porsi ad una distanza pari ad 1,5 volte l’altezza dello schermo. Per uno schermo da 60 pollici significa collocarsi ad 1 metro e mezzo. Davvero vicino. In Figura 1 un grafico più dettagliato.

Figura 1. Risoluzione e distanza di visione: dal momento che il nostro occhio oltre una certa distanza non è più in grado di percepire come distinti due punti molto vicini tra loro (potere risolutivo), la risoluzione di un display sarà pienamente percepita solo entro una certa distanza, oltre la quale diventerà non più distinguibile da una inferiore. Il diagramma consente di individuare il range di distanza di visione ottimale a seconda delle dimensioni dello schermo e della sua risoluzione.

Vi invito a riflettere sul fatto che nel Digital Cinema 4K la risoluzione (4.096×2.160) è molto simile a quella dell’UHD, tant’è che i termini “4K” e “UHD” sono divenuti quasi “sinonimi”, anche se in linea di principio il primo fa riferimento al cinema ed il secondo alla televisione. Se la risoluzione 4K basta per il cinema, dove la diagonale dello schermo può superare tranquillamente i dieci metri, potrebbe diventare diciamo “sovrabbondante” per la TV, proprio per la questione della distanza di visione, se non stiamo sufficientemente vicini allo schermo, come purtroppo molto spesso accade. Per questo dicevo che l’aumento di risoluzione è l’aspetto che contribuisce al realismo delle immagini nella misura meno determinante, perché talvolta lo sacrifichiamo, magari inconsapevolmente. Inten-diamoci, l’aumento di risoluzione comporta benefìci palesi, direi di enorme portata. Ma il benefico effetto del quadruplicato numero di pixel tende a diminuire al crescere della distanza di visione, col rischio di sparire del tutto se si commettono grossolani errori di posizionamento del televisore.

Non solo più pixel

Gli altri due aspetti, quello colorimetrico e quello della luminosità, invece non sono legati in alcun modo alla distanza di visione; inoltre il loro contributo al maggior realismo della resa è indipendente dalla risoluzione, reale o percepita, tanto è vero che nell’ultima edizione del CES di Las Vegas sono state presentate da Sony alcune linee di TV Full HD con HDR, anche se con una serie di limitazioni (HDR solo per giochi e video in streaming).

Per quanto riguarda le nuove potenzialità in termini di riproduzione dei colori, l’UHD porta con sé due novità: gamut più ampio, di solito indicato con WCG (Wide Color Gamut), e maggiore profondità del colore, ovvero più bit per componente. Su questi progressi introdotti con l’UHD si basa anche l’HDR. Vale quindi la pena spiegare questi aspetti con un minimo di dettaglio, per comprenderne meglio le implicazioni. Il termine gamut indica l’insieme dei colori che un dispositivo di visualizzazione (display, stampante, proiettore ecc.) è in grado di riprodurre, come anche l’insieme dei colori che un dispositivo di ripresa (foto/videocamera, scanner ecc.) è in grado di catturare.

Per rappresentare questi insiemi di colori sono stati introdotti diversi modelli matematici, che permettono di rappresentare ciascun colore con una terna o una quaterna di numeri (coordinate cromatiche dello spazio colore). In quanto “strumento di cattura”, anche l’occhio umano ha un suo gamut, il cui studio ha portato nel 1931 alla definizione di “Osservatore Standard” ed al relativo grafico CIE 1931. Si tratta di studi piuttosto complessi, perché accanto a grandezze fisiche misurabili, entrano in gioco anche fattori “umani” legati alla percezione. Si assume ad esempio che la “risposta” dell’occhio sia l’effetto combinato di tre stimoli distinti: rosso, verde e blu (di solito indicati con R, G e B dall’inglese Red, Green, Blue).

In teoria la rappresentazione del gamut dell’occhio non potrebbe giacere su un piano come il CIE 1931, perché quand’anche la rappresentazione del singolo colore fosse bidimensionale (e già questo non è possibile se si utilizzano tre numeri per identificare il singolo colore), occorrerebbe comunque considerare la risposta dell’occhio al variare dell’intensità dello stimolo luminoso, il che ricondurrebbe almeno ad una rappresentazione 3D. Ricorrendo per la seconda volta ad una sintetizzazione estrema, possiamo dire che il grafico CIE 1931 che normalmente utilizziamo è una particolare proiezione bidimensionale di questa rappresentazione 3D. Un display ideale dovrebbe essere in grado di riprodurre tutto lo spettro dei colori visibili, ma attualmente nessun prodotto in commercio è in grado di arrivare a tanto.

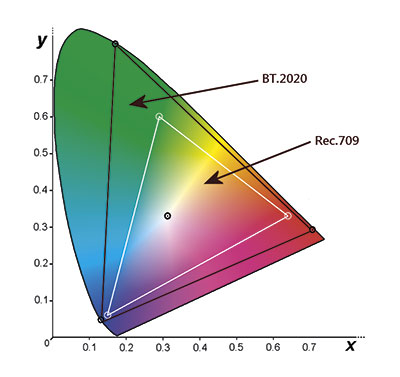

Il gamut di un normale display è sempre un sottoinsieme del gamut dell’occhio. E la forma con cui viene rappresentato sul grafico CIE 1931 è sempre quella di un triangolo. Il motivo è legato alla modalità in cui i colori vengono generati. Abbiamo già ricordato che ogni singolo pixel è in realtà composto da una terna di sub-pixel RGB, percepiti come una unica entità per i limiti del potere risolutivo dell’occhio. I tre vertici del triangolo di gamut individuano il rosso, il verde ed il blu più “profondi” che il display può generare. Poiché tutti gli altri colori che il dispositivo può emettere altro non sono che una somma dei tre primari, i punti che li rappresentano sul grafico CIE 1931 non possono andare al di fuori dei tre segmenti che rappresentano i colori ottenibili miscelando a due a due i tre primari. I colori giallo, magenta e ciano “puri” si trovano appunto sui segmenti che uniscono rispettivamente R e G, R e B ed infine G e B. Se fino a qui è tutto chiaro, come mi auguro, posso rimandarvi alla Figura 2, dove vediamo a confronto i gamut di riferimento della HDTV (Rec.709) e dell’Ultra HD (BT.2020).

Figura 2. I colori dell’UHD: confrontando l’insieme dei colori visualizzabili nell’HDTV con quelli dell’UHD si vede immediatamente quale balzo in avanti sia stato fatto in termini di resa colorimetrica. Il nuovo standard riesce a coprire (potenzialmente) il 76% dell’insieme dei colori che riusciamo a vedere. Lo standard dell’HDTV si fermava al 36%.

L’insieme Rec.709 è quasi identico a quello della definizione standard (Rec.601 ) e copre circa il 36% dello spazio dei colori visibili. Il BT.2020 è invece molto più ampio e arriva a coprire il 76% del visibile. È importante notare che anche lo spazio BT.2020 non può essere totalmente riprodotto da un display commerciale. Esso va inteso come un “contenitore” all’interno del quale è “calato” il nostro messaggio video. Riprenderemo questo concetto poco più avanti, parlando della luminosità.

Occorre poi tener presente che gli insiemi di colori così descritti, più o meno ampi che siano, restano pur sempre delle entità fisiche “continue”: le sfumature possibili sono, all’interno di questi insiemi, teoricamente infinite. La gestione di segnali per memorizzare, trasmettere e riprodurre infinite sfumature sarebbe possibile solo con un sistema analogico. Ma sappiamo che il nostro mondo video è digitale, con tutti i vantaggi ed i limiti che questo implica.

Passiamo quindi all’altro aspetto di cui facevamo cenno, la profondità del colore. Con questa espressione ci si riferisce al numero di bit utilizzati per il campionamento del colore. Prima dell’arrivo dell’UHD, il colore era gestito con 8 bit per componente. Tutto sommato il numero di bit può essere considerato un dettaglio “trasparente” per il generico utente finale di video, che inserisce i DVD o i BD nel lettore, accende il decoder satellitare o guarda il digitale terrestre senza doversene preoccupare.

Credo anche che chi ha un minimo di esperienza (leggi età) in campo informatico ed ha attraversato la fase degli sviluppi delle schede video e delle risoluzioni (VGA, SVGA, XGA ecc. ecc.), avrà sperimentato sulla sua pelle, anzi sul suo monitor, le differenze con le varie profondità di colore. Sono comunque certo che tutti sappiano che con una profondità del colore di 24 bit (8 bit per componente) si possano ottenere più di 16 milioni di diverse sfumature. Il punto nodale però è che questi 16 milioni di colori sono ottenuti dalla combinazione di 256 possibili sfumature di rosso, moltiplicate per 256 possibili sfumature di verde, per 256 sfumature di blu. E già… Questo perché con 8 bit si possono rappresentare i numeri da 0 a 255, ovvero 256 diversi “livelli”.

Quindi 256 diversi livelli (teorici perché non sempre si usano tutti i livelli disponibili) per i tre colori primari puri, ed anche solo 256 possibili sfumature di grigio, che come è noto è ottenuto dalla somma di tre valori uguali delle tre componenti. Tutti i televisori utilizzano delle elaborazioni per eliminare o ridurre il più possibile il “banding”, termine con il quale si indica il difetto dei gradienti cromatici non uniformi, ma a “scalini”. Se volessimo disegnare sullo schermo UHD delle righe orizzontali grigie, ognuna alta un pixel e diversa dall’altra, partendo dal nero per arrivare al bianco, quindi 2.160 sfumature di grigio, 10 bit non basterebbero, perché le sfumature possibili con 10 bit sono 1.024.

La situazione peggiora se il gradiente fosse orizzontale. Ma questi sono davvero casi limite, nei quali ci si può imbattere solo con dei pattern di test e non con un video reale. La scelta per lo standard base è stata quella di utilizzare 10 bit per componente, per un totale di poco più di un miliardo di diversi colori.

Immagini più luminose

La quasi totalità dei televisori Full HD provati nel corso degli anni nel nostro laboratorio esibiva una luminosità massima compresa tra i 350 ed i 500 nit, a volte qualcosa in più. Le specifiche Premium, introdotte poco più di un anno fa dalla Ultra HD Alliance, consorzio che comprende costruttori di apparecchi, creatori e distributori di contenuti, prevedono che i display HDR debbano garantire una luminosità di almeno 1.000 nit, unitamente ad un livello del nero non superiore a 0,05 nit.

Esiste anche un’altra specifica, pensata per gli OLED, ai quali è richiesta una luminosità massima un po’ più bassa ma un livello del nero più contenuto. Diversi TV presentati al CES all’inizio di quest’anno arrivano ad offrire oltre 1.500 nit di luminosità massima, ed anche gli OLED hanno fatto un discreto balzo in avanti in termini di luminosità di picco. A mio avviso questa maggiore luminosità, assieme alla maggior ricchezza cromatica, di cui i display HDR sono capaci, contribuisce in misura determinante al realismo delle immagini che questi apparecchi offrono.

Per sfruttare al massimo queste potenzialità hardware, dal momento che le sfumature di colore (o, se volete, i livelli di grigio) sono rappresentati nel dominio digitale con 10 bit, è stato necessario introdurre una opportuna EOTF (Electro-Optical Transfer Function), per ottimizzare la cattura e la riproduzione dei dati video; nel caso dei dispositivi di cattura, la funzione di trasferimento è detta Opto-Electrical (OETF). Codifica e riproduzione devono ovviamente avere funzioni di trasferimento complementari, in modo che il processo di cattura-codifica-riproduzione sia lineare, ovvero che il display riproduca quello che la videocamera ha “visto” (o che il colorista in postproduzione ha deciso di mostrare).

Stiamo complicando una cosa semplice? Se ci pensate, però, è dall’inizio della nostra storia di videofili che abbiamo a che fare con una di queste funzioni di trasferimento: il famoso “gamma” dei televisori. Tutto ebbe inizio con la nascita stessa della televisione e con l’utilizzo del tubo catodico, la cui risposta è tutt’altro che lineare.

Nei tubi CRT infatti l’intensità luminosa emessa dipende in misura esponenziale dalla tensione applicata. Pertanto nel processo di gestione dei segnali video si dovette tenere conto di questa non linearità, compensandola, in fase di “produzione”, con una curva inversa, in modo che quanto visualizzato dal TV fosse corretto.

Poi arrivarono gli schermi piatti. Plasma ed LCD non avevano il problema della “risposta esponenziale”, nondimeno dovevano aderire agli standard fissati per i segnali; era quindi compito della loro elettronica trattare i segnali in ingresso per fornire una risposta lineare. Ma perché nel passaggio all’UHD è stato necessario introdurre di nuovo una funzione di trasferimento, per di più diversa da quella già utilizzata? Le specifiche dell’HDR impongono che i supporti preregistrati, i lettori ed i display utilizzino la EOTF definita dallo standard SMPTE ST2084.

A cosa è legata questa scelta? Perché non bastava una semplice codifica lineare? Accennavamo poco sopra che un TV HDR ha un range di luminosità che spazia dai 0,05 nit fino ad almeno 1.000. Esistono già pannelli capaci di arrivare anche a 5.000 nit, anche se non concepiti per l’Home Theater domestico. E nel fissare le specifiche dello standard, è stato deciso che il sistema dovesse essere in grado di gestire addirittura fino a 10.000 nit. Anche se, al momento, non ci sono display così luminosi, c’è comunque da considerare l’aspetto della creazione di contenuti, ove occorre fare i conti con la smisurata dinamica luminosa del mondo che ci circonda.

L’utilizzo di una funzione non lineare si è reso necessario proprio per gestire al meglio un range di luminosità che, almeno in teoria, viaggia da zero a 10.000 nit. Per arrivare a definire questa funzione, sono stati presi in considerazione due fattori: la risposta dell’occhio ed il numero di bit a disposizione per rappresentare i livelli di intensità. Anche in questo caso sono stati fatti approfonditi studi sulla capacità dell’occhio di discernere piccolissime variazioni tra livelli di grigio a diverse intensità (studi di Barten, Fig. 3, iniziati credo per lo sviluppo di display medicali in grado di visualizzare le radiografie con tutte le microsfumature della lastra sviluppata). Inutile utilizzare tanti bit quando l’occhio non è in grado di percepire piccole variazioni, meglio riservarseli negli intervalli di luminosità ove l’occhio è più sensibile.

Figura 3. Studi di Barten sulla percezione: per arrivare a definire la “curva del gamma” per l’HDR, ci si è basati anche su studi relativi alla capacità di un osservatore di percepire piccole sfumature di luminosità al variarne dell’intensità. La figura mostra la soglia che questi studi hanno individuato e che è servita per ottimizzare la funzione di trasferimento nella codifica dei livelli nello standard ST2084, detta “Rampa di Barten”. La zona in verde, al di sotto della soglia, individua il campo in cui, in date condizioni di intensità, il piccolo salto tra due livelli non viene percepito. In questa zona i gradienti ci appaiono uniformi. Al di sopra della soglia, l’occhio percepisce la variazione ed i gradienti appaiono scalettati. In figura la curva in nero, indicata con 12 bit PQ (Perceptual Quantizer, altro modo con cui viene chiamata proprio in virtù della sua natura), vediamo la curva ST2084: è sempre al di sotto della soglia ma sempre prossima ad essa. Una curva gamma classica, anche a 10 bit, lavora male alle basse luci. Utilizzando 15 bit si passa in “zona verde” ma c’è spreco di risorse al crescere dell’intensità, man mano che ci si allontana dalla soglia (vengono cioè usati più bit del necessario). Una curva logaritmica a 13 bit ha il difetto opposto: spreca risorse alle basse luci. La figura mostra anche una curva usata per il salvataggio di file grafici. (Fonte: SMPTE)

Arriviamo quindi alla terza sintesi estrema: la SMPTE ST2084 è la “curva del gamma” dell’HDR (Fig. 4). Non tutti i televisori UHD sono necessariamente HDR, anche se percentualmente la loro presenza nei cataloghi si sta riducendo. E non tutti i TV HDR hanno lo stesso gamut e la stessa luminosità massima.

Figura 4. Curva ST2084: utilizzata sia nell’HDR 10 che nel Dolby Vision, la curva definita nello standard SMPTE ST2084 prende il posto della “vecchia” curva del gamma. Questo standard consente di trattare livelli di luminosità fino a 10.000 nit. Questa funzione di trasferimento è stata ottimizzata anche in base a studi sulla percezione. A differenza di quanto avviene nell’SDR, in cui si opera in un “ambiente normalizzato” (con questo intendo dire che i rapporti in/out sono gestiti indipendentemente dalla reale intensità fisica dei segnali), la codifica in digitale dei livelli di luminosità operata attraverso questa curva fornisce i livelli fisici in bit. Per questo deve essere accompagnata da metadati che consentano al display di gestire opportunamente il flusso binario, in base alle proprie caratteristiche fisiche (gamut, luminosità massima).

Implementare l’HDR

Arriviamo quindi all’ultimo passo di questa chiacchierata, che riguarda la modalità con cui l’HDR è implementato. Abbiamo fatto una serie di premesse, che ci consentono ora di confrontare le “varianti” dell’HDR con cui abbiamo o avremo presto a che fare. Ma ci manca ancora un elemento, che riguarda l’interazione tra sorgente e display, aspetto che nell’HDTV non esisteva, almeno non a questo livello. Per illustrare questo concetto riprendiamo da quanto detto in chiusura del paragrafo precedente: non tutti i TV UHD sono HDR e non tutti hanno lo stesso gamut e la stessa luminosità massima.

Per rendere compatibile i contenuti HDR con i display solo UHD, si è reso necessario separare le informazioni riguardanti l’HDR da tutto il resto, in modo che i dispositivi non HDR (detti quindi SDR, Standard Dynamic Range) possano semplicemente ignorarle. Nei supporti preregistrati, quindi, sono inseriti dei contenuti supplementari, dei cosiddetti metadati, che “spiegano” al display cosa c’è nel disco, in particolare riguardo all’insieme dei colori utilizzato (che può essere tutto il BT.2020 o un sottoinsieme), alla luminosità massima del contenuto (Maximum Content Light Level, MaxCLL), al massimo valore medio della luminosità del singolo frame (Maximum Frame Average Light Level, MaxFALL), alla luminosità del display usato per la post-produzione. La codifica HDR quindi non è basata solo su cosa la videocamera (o la computer grafica…) ha catturato, anche sul dispositivo usato per la visualizzazione in post-produzione.

In base a queste informazioni il TV HDR, che “conosce” il suo gamut e la sua luminosità, esegue una vera e propria operazione di adattamento del contenuto per riprodurlo al meglio delle sue possibilità, in base alle sue stesse caratteristiche. Non esistono delle specifiche su come questa operazione debba essere fatta. Per quanto attiene alla luminosità, il display potrebbe decidere di clippare tout-court tutte le informazioni che si collocano al di sopra della propria luminosità massima. Oppure potrebbe utilizzare una sua curva di adattamento più o meno sofisticata. O infine, ed è l’unica opzione possibile per un display SDR, “riscalare” tutto verso il basso, assumendo che la massima luminosità del disco coincida con la propria, con l’effetto però di abbassare la luminosità media di tutto il contenuto. Al momento vi è una sola versione di HDR “obbligatoria” sui supporti preregistrati, che i lettori devono riprodurre e i display visualizzare.

È l’HDR 10. In questa implementazione i metadati dell’HDR sono statici, ovvero definiti ed invariabili per tutta la durata del contenuto. Il TV quindi opererà, nell’adattamento del contenuto alle proprie caratteristiche, sempre allo stesso modo. Nella pratica il sistema funziona in maniera eccellente, anche se si tratta di una soluzione rozza. Funziona bene perché alle spalle c’è una gestione del “gamma” ben congegnata, ma è un sistema rozzo perché non ottimizza le risorse, soprattutto se la post-produzione è stata fatta con un monitor molto luminoso. La soluzione si chiama Dolby Vision. Questa implementazione dell’HDR non è “obbligatoria” e ogni costruttore decide se implementarla o meno. Due sono le differenze con l’HDR 10. La prima riguarda la gestione dei metadati, che non sono statici ma dinamici.

Questo significa che possono essere definiti scena per scena, al limite frame per frame. In questo modo il lavoro di adattamento della luminosità avviene solo quando quella descritta nei metadati eccede quella fisica del display. In tutti gli altri casi la gamma dinamica del sistema verrà sfruttata tanto meglio quanto più “fitto” è il flusso di metadati, ovvero quanto più frequentemente i metadati vengono aggiornati al contenuto istantaneo. Se questo lavoro in post-produzione (lavoro che ovviamente ha un costo) non viene fatto accuratamente, il vantaggio del Dolby Vision rispetto all’HDR 10 tende a sparire. La seconda differenza riguarda il numero di bit, che nel Dolby Vision sono 12. La differenza non è da poco: i livelli passano da 1.024 a 4.096, per un totale di oltre 68 miliardi (!) di sfumature. Tutte e due le implementazioni descritte, le cui differenze sono riassunte in Figura 5, debbono provvedere al riadattamento del colore; anche per questa operazione non esiste una prassi di riferimento obbligatoria per l’HDR 10, ogni costruttore adotta la propria strategia. Probabilmente tutti i display con chip Dolby Vision operano allo stesso modo.

Figura 5. HDR 10 vs Dolby Vision: la differenza più importante tra i due sistemi di codifica dell’HDR risiede nella gestione dei metadati, statici nell’HDR 10 e dinamici nel Dolby Vision. Quest’ultimo consentirebbe pertanto il massimo sfruttamento dell’hardware, poiché permette di adattare costantemente il processo di codifica alle caratteristiche del contenuto, fino al teorico livello frame by frame. Sempreché venga fatto il relativo lavoro in fase di creazione del contenuto.

Resta da considerare un ultimo aspetto, quello del broadcast, soprattutto per quanto riguarda gli eventi live, in cui le possibilità di intervento real time sono limitatissime. Lo standard per l’HDR nelle trasmissioni televisive si chiama Hybrid Log-Gamma (HLG), ed è stato sviluppato dai colossi britannici e giapponese BBC e NHK. Il nome deriva dal fatto che la funzione di trasferimento è in parte logaritmica e in parte esponenziale (come una classica curva “gamma”) (Fig. 6).

Figura 6. Curva Hybrid Log-Gamma: sviluppata dalla britannica BBC e dalla nipponica NHK e già supportata da qualche costruttore, sarà probabilmente la funzione di trasferimento per veicolare l’HDR nelle trasmissioni televisive. Non vengono utilizzati metadati ed è direttamente retrocompatibile con i display SDR. Ottimizzata per un range di luminosità fino a 2.000 nit, risente poco delle differenze di prestazioni in termini di luminosità massima dei display attualmente in commercio e di quelli di prossima introduzione.

Questo standard ha il pregio di essere compatibile con i display SDR (non vengono trasmessi metadati, alcuni dei quali, come i valori massimi di luminosità, non sono disponibili in una diretta) e funziona molto bene al variare della luminosità del display utilizzato. Il motivo è legato al limite stesso del sistema, quello di considerare come limite superiore dell’intervallo di luminosità il valore di 2.000 nit, ben lontano dai 10.000 teoricamente possibili con l’HDR 10 e il Dolby Vision, ma comunque perfettamente equilibrato con le attuali potenzialità dei display HDR. I televisori SDR non taglieranno i dettagli tutti sulle alte luci, limitandosi a visualizzarli senza “boost” luminoso, mentre gli HDR avranno la tipica marcia in più.

Conclusioni

Mi auguro che, se siete arrivati fin qui, abbiate preso un po’ di dimestichezza con diversi nomi dell’HDR. Ma quello che conta è l’uso che possiamo fare di queste informazioni, rendendoci più consapevoli al momento dell’acquisto di un nuovo apparecchio, TV o lettore che sia. Il Dolby Vision non è uno standard obbligatorio; sui Blu-ray UHD ci sarà sempre e comunque l’HDR 10. Quando presente, la traccia Dolby Vision potrebbe dare qualcosa in più (i primi titoli sono previsti quest’anno).

Uso il condizionale perché una comparazione dello stesso titolo nelle due versioni non ho avuto modo di farla. Non mi fascerei la testa se già possedessi un buon TV HDR non compatibile Dolby Vision, perché comunque l’HDR 10 offre risultati fantastici. Potrebbe essere spiacevole il caso di contenuti in streaming disponibili solo in Dolby Vision. Per L’Hybrid Log-Gamma mi preoccuperei ancor meno, visto che le trasmissioni in 4K non sono proprio all’ordine del giorno, ma potendo scegliere non trascurerei questa opzione. In questo articolo non abbiamo parlato di un’altra implementazione, la SL-HDR1 (Philips, Technicolor). Se ne varrà la pena torneremo anche su questa. Intanto grazie per aver resistito a leggere fino in fondo…

Mario Mollo